什么是 Databricks?它的主要功能是什么?

Databricks 是一个基于云的数据分析平台,旨在简化大数据处理和人工智能(AI)工作流。它结合了大数据处理、数据工程和数据科学的功能,提供了一种统一的分析解决方案,帮助企业更高效地处理和分析数据。Databricks 的核心组成部分是基于 Apache Spark 的云数据平台,其主要功能包括数据处理、分析、机器学习和数据协作。本文将详细介绍 Databricks 的定义、主要功能及其在数据分析中的应用。

1. Databricks 的定义

Databricks 是由 Apache Spark 的创始团队在 2013 年创建的云数据平台,旨在提供一个集成的大数据处理环境。它通过简化大数据处理的复杂性,使数据工程师、数据科学家和分析师能够更快速地构建、训练和部署数据驱动的应用程序。Databricks 提供了一个协作工作空间,支持大规模的数据处理、机器学习和实时数据分析,并与多个云服务提供商(如 AWS、Azure 和 Google Cloud)紧密集成。

2. Databricks 的主要功能

2.1 基于 Apache Spark 的数据处理

Databricks 的核心是基于 Apache Spark 的分布式数据处理引擎。Apache Spark 是一个开源的大数据处理框架,以其高性能和易用性著称。Databricks 提供了一个托管的 Spark 环境,用户可以轻松地运行大规模的数据处理作业,而无需管理复杂的集群配置和维护工作。主要功能包括:

- 批处理:处理大规模的历史数据,进行数据清理、转化和聚合。

- 流处理:实时处理数据流,如实时日志分析和实时数据管道。

- 交互式查询:支持 SQL 查询和数据探索,提供低延迟的查询响应。

2.2 数据湖和数据仓库集成

Databricks 允许用户将数据存储在数据湖(如 Amazon S3、Azure Data Lake Storage)中,并提供了强大的数据处理能力来分析这些数据。它支持将数据从数据湖导入到 Databricks 中进行处理,也可以将处理后的数据存储回数据湖。此外,Databricks 还支持与传统数据仓库系统(如 Snowflake、Redshift)集成,以实现数据的无缝迁移和分析。

2.3 机器学习和 AI

Databricks 提供了全面的机器学习支持,帮助用户从数据准备到模型训练再到模型部署的整个流程。主要功能包括:

- MLflow 集成:MLflow 是一个开源的机器学习生命周期管理工具,它集成在 Databricks 中,支持实验管理、模型跟踪和模型部署。

- AutoML:自动化机器学习工具可以帮助用户自动选择特征、调整模型参数并评估模型性能,从而简化机器学习过程。

- 深度学习支持:提供对 TensorFlow、PyTorch 等深度学习框架的支持,方便构建和训练深度学习模型。

2.4 数据科学和协作

Databricks 提供了一个协作工作空间,使数据科学家和分析师能够更高效地进行数据分析和探索。主要功能包括:

- Notebook 环境:支持 Jupyter 风格的交互式笔记本,允许用户以代码、文本和可视化的形式记录和分享分析过程。

- 实时协作:团队成员可以实时协作,共享和编辑笔记本,进行集体数据分析和讨论。

- 数据可视化:提供丰富的可视化工具,帮助用户直观地理解数据和分析结果,包括图表、地图和仪表板等。

2.5 集成与 API

Databricks 提供了丰富的集成功能和 API,使得用户可以将 Databricks 与其他系统和工具结合使用。主要功能包括:

- 连接器:支持与多种数据源的连接,如关系型数据库、NoSQL 数据库、云存储等。

- REST API:通过 REST API,用户可以编程访问 Databricks 的功能,包括作业管理、集群操作、数据管理等。

- 第三方工具集成:支持与各种分析和可视化工具的集成,如 Tableau、Power BI、Looker 等。

3. Databricks 的应用场景

Databricks 在多个领域有广泛的应用,包括:

- 金融服务:用于实时交易分析、风险管理和合规检查。

- 零售:通过分析客户行为数据来优化库存管理和个性化推荐。

- 医疗保健:用于处理和分析患者数据,支持临床研究和药物发现。

- 制造业:通过实时监控和预测分析优化生产流程和设备维护。

4. 总结

Databricks 是一个强大的基于云的数据分析平台,提供了全面的数据处理、分析和机器学习功能。通过集成 Apache Spark、大数据处理、机器学习、数据科学和协作功能,Databricks 能够帮助企业高效地处理和分析数据,支持从数据准备到模型部署的整个流程。无论是在金融服务、零售、医疗保健还是制造业,Databricks 都能提供强大的支持,提升数据驱动决策的能力。

5.其他补充

Databricks是全球数据与AI 整合的领航者

Databricks是一个由Apache Spark 团队创办的资料分析平台,作为领先业界的资料分析平台,Databricks 无缝整合了资料工程、资料科学、商业分析、机器学习等关键工作流程,彻底颠覆传统数据处理的繁琐与低效,协助企业快速处理与分析大量的资料。

此外,Databricks 的最大优势在于其云端原生架构。 Databricks 原生支援多种云端平台(如AWS、Azure、Google Cloud),让使用者无需担心底层基础设施,可将宝贵的资源和时间,专注于更有价值的资料分析应用上与创新,加速实现数据驱动的商业目标。

Databricks核心概念:打造高效数据工作流程

在深入了解Databricks 的强大功能之前,不妨先掌握几个基本概念,将有助于您更好地理解其运作方式:

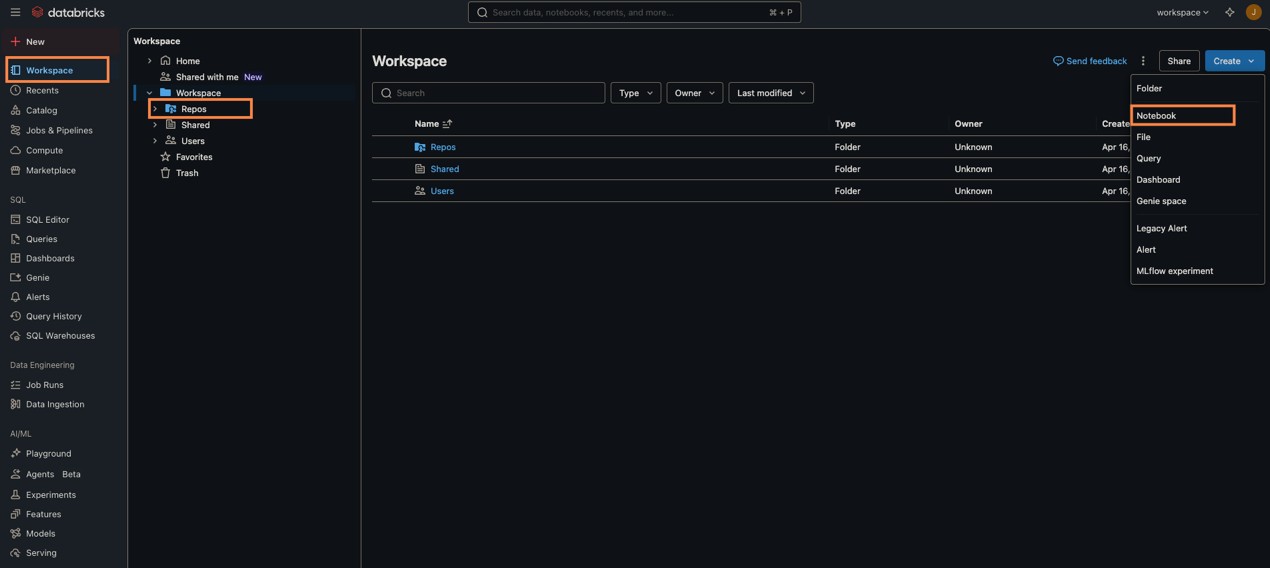

Workspace (工作区):您的数据指挥中心

Workspace是存取所有的Databricks 资源的主要环境,透过直观的资料夹方式,统一分类并管理各种数据物件,包含Notebooks、Libraries、Dashboards、 和Experiments 等。它更提供精细化的权限控管机制,方便使用者控管资料物件和运算资源的存取权限、存取安全和合规性,可谓团队协作的数据指挥中心。

Notebook (笔记本):互动式数据实验室

Notebook是一个互动式的网页应用介面,让使用者能够在同一页面中,流畅地撰写可执行的程式码(支援多种语言,如Python、Scala、SQL、R)、生成视觉化图表与说明文字。这大大提升了资料处理、分析流程与机器学习模型的开发效率和可读性。

Repos (代码库):Git 整合的开发利器

Repos提供与Git 储存库的深度整合能力,让开发者能将Notebook 和原始码轻松同步至GitHub 、GitLab 或Bitbucket 等Git平台,实现专案版本控制,并提供专案的来源,有助团队管理原始码版本、追踪修改历程,确保专案的可追溯与一致性。

Databricks 的 Workspace(工作区)、Notebook(笔记本)、Repos(代码库)

突破数据孤岛:Databricks Lakehouse湖仓一体的核心技术及优势

长期以来,随着企业资料量快速增长,企业正面临「数据孤岛」与「复杂治理」的双重挑战:

资料孤岛:企业资料时常散落在多个来源中,企业将各种格式(包括结构化、半结构化、非结构化)的原始资料存在资料湖,需进行大量分析的结构化资料则放在资料仓储,使企业需维护独立的资料系统,不仅大幅增加管理成本,也造成资料格式不一致等问题,导致资料价值无法有效发挥。

复杂的资料治理:在分散的数据环境中,难以追溯资料来源及集中管理资料访问权限,进一步提高了资料治理的复杂性。

而Databricks所推出的革命性Lakehouse(湖仓一体) 架构,正是为了解决这些痛点而生。Databricks 整合了Data Lake 的「弹性与规模」与Data Warehouse 的「查询效能及资料治理能力」。这款创新的架构,让企业可以在同一个平台上完成所有资料相关作业,避免使用孤立系统来处理不同的工作负载,大幅简化系统架构,使资料团队能迅速运用数据,而无需跨多个系统查询。

此外,Databricks Lakehouse 还整合了以下您不可不知的关键技术:

Delta Lake (数据一致性与时间追溯的基石):支援ACID 交易的储存层,确保资料写入的一致性与可靠性,并提供时间旅行Time Travel、版本控制与即时查询能力。

Unity Catalog (跨平台统一数据治理):统一的资料目录与存取控管系统,支援跨工作区与云环境的治理,提升资料安全性与合规性。

单一工作平台(提升团队协作效率):将资料工程、资料科学、BI 分析与机器学习整合于同一工作空间,提升团队协作效率,避免工具切换造成的摩擦。

Lakehouse (湖仓一体)架构整合了Data Warehouse 的结构化管理优势,以及Data Lake 的灵活性,提供统一的资料平台解决方案

Databricks Lakehouse 适用哪些应用情境?

Databricks Lakehouse平台的强大功能,使其成为多种关键商业应用场景的首选,已为无数企业驱动创新并加速决策:

加速商业分析:无缝整合来自ERP、CRM、CSV 上传、第三方系统等多元资料源。在Lakehouse 上做统一查询与生成报表后,可再整合Power BI、Tableau 或Databricks SQL 进行即时仪表板展示,实现数据驱动的敏捷决策。

高效IoT 资料处理:轻松搜集来自IoT 的即时串流设备资料,并与结构化资料结合,进行生产效率分析、预测性维护等应用,提升整体营运效率。

机器学习与AI 模型开发:从资料前处理→ 特征工程→ 模型训练→ 模型部署与版本控管,整个机器学习生命周期都能在Databricks 平台上顺畅完成。且平台原生支援MLflow 管理,简化模型管理与追踪的复杂性,加速AI 应用落地。

评论